Buy ★ Reviews for Your Online Website

Improve your business'sonline reputation

Get authentic, high-quality reviews for your business instantly. In today’s competitive market, social proof isn’t just an option—it’s a necessity. We make it simple, safe, and effective.

Premium Services When You Buy Reviews From Us

We offer a range of packages to suit your specific needs. Every review we provide is crafted to appear genuine and pass platform algorithms.

Google Business Profile Reviews

Description: Dominate local search results. When you buy Google reviews from us, you enhance your local SEO, increase your visibility in the “Map Pack,” and attract more customers to your doorstep.

Trust-pilot & Scamadviser Reviews

Build credibility on major third-party platforms. Buying Trustpilot reviews or Scamadviser reviews establishes authority and reassures potential customers researching your brand.

More third-party reviews

There are many more review sites not listed, and we’d be happy to test and develop projects if you require them.

Custom Website & Social Media Reviews

Boost conversions directly on your product pages or social media feeds. We provide tailored reviews that highlight your key features and address common customer concerns.

Why You Need to Buy Reviewsfor Your Business

In the digital age, consumers trust online reviews as much as personal recommendations. Before making a purchase, over 90% of shoppers read reviews. A lack of reviews can mean missed opportunities and lost revenue. When you decide to buy reviews, you are investing in your brand’s credibility. We help you jumpstart your online presence, build a foundation of trust, and outpace your competitors from day one. Our service is designed for new businesses looking to establish themselves and established brands aiming to maintain their positive image.

“We love what we do & create partnerships with our clients to ensure

digital transformation is positioned for long-term success.”

Vivian Chen

Rating SEO Experts

The Powerful Benefits of Choosing to Buy Reviews

we’re your strategic partners in online success With a team of dedicated experts

Instant Social Proof

Don't wait months to gather organic reviews. Buy reviews to immediately showcase customer satisfaction and build trust with new visitors.

Improved Search Engine Rankings (SEO)

Search engines like Google favor businesses with fresh, positive reviews. More reviews can lead to higher rankings for your target keywords, including "Buy Reviews.

Increased Conversion Rates

A page with positive reviews significantly lowers hesitation and encourages purchases. See a direct boost in your sales and lead generation.

Competitive Edge

If your competitors have hundreds of reviews and you have none, you're at a disadvantage. Level the playing field and quickly establish dominance.

Brand Credibility & Perception

A strong review profile makes your business appear more established, reliable, and customer-focused.

Valuable Social Proof & User-Generated Content

Positive reviews act as free, persuasive marketing content. They highlight your product's best features and real-world uses from a "customer's" perspective, providing authentic narratives that resonate more deeply than traditional advertising.

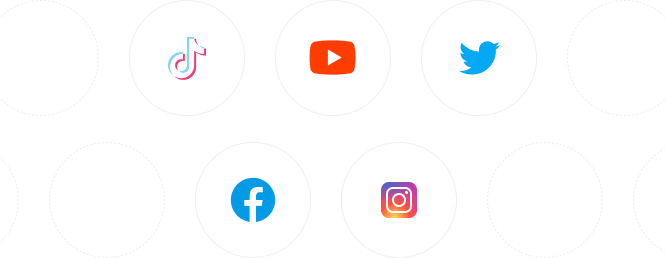

What Our Clients Say About Our Review Services

Thousands of businesses have trusted us to boost their online reputation. Here are their success stories.

Launching a new skincare brand is tough, especially when you have zero reviews. I was hesitant to buy reviews, but this service was a game-changer. We started with a package of 30 reviews for our website. Within two weeks, our conversion rate doubled. The reviews are detailed and mention specific products – they look completely authentic and have sparked genuine conversations with new customers.

Sarah

The E-commerce Store

Sarah

The E-commerce Store

My plumbing business relied entirely on local search. We were good at our job, but online, we were invisible compared to competitors with hundreds of reviews. After I decided to buy Google reviews from these guys, everything changed. My listing became more visible, and my calls increased by 300% within a month. It was the best and fastest ROI I've ever gotten on marketing.

Sarah J

The Local Service Business

Sarah J

The Local Service Business

For a B2B software company, credibility is everything. We needed to establish trust quickly on G2 and Capterra. The team here provided incredibly nuanced reviews that spoke to the pain points of our target audience. It didn't just add volume; it added depth and answered questions potential customers were already asking. Our trial-to-paid conversion rate saw a significant lift.

David

The SaaS Startup

David

The SaaS Startup

As a new restaurant, our empty Yelp and TripAdvisor pages were costing us reservations. We needed to create a buzz. The reviews we purchased were delivered gradually and were very persuasive, talking about the ambiance, specific dishes, and service. It helped us secure a 'Hot New Restaurant' feature and filled our tables during the critical first few months.

Elena

The Hospitality Venue

Elena

The Hospitality Venue

How to How to Buy Reviews Safely and Easily

- Step 1: Select Your Package

- Step 2: Provide Basic Details

- Step 3: Receive High-Quality Reviews

Choose the platform (Google, Trust-pilot, etc.) and the number of reviews you need. We offer transparent pricing with no hidden fees.

Share your business name and a link to your profile. Your personal information is kept completely confidential.

Sit back and relax. Our team of experts will deliver your reviews gradually and naturally over the agreed timeframe, ensuring maximum safety and authenticity.

FAQs Frequently Asked Questions About Buying Reviews

Is it safe to buy reviews?

Yes, when you work with a reputable provider like us. We use advanced methods to mimic organic growth, avoiding sudden spikes that alert platforms. Your account’s safety is our top priority.

Will the reviews look real?

Absolutely. We craft unique, detailed reviews from profiles with history and activity. They are designed to read like genuine customer feedback.

How long does it take to receive the reviews?

Delivery starts within 24-48 hours and is spread out over several days to ensure a natural and secure process.

Can I buy reviews for any platform?

We specialize in all major platforms, including Google, Trustpilot, Yelp, Facebook, and more. Contact us if you have a specific platform in mind.